2013 № 1 (6)

В поисках «Южного материка» или Экспедиция через виртуальный океан

Музыка способна исходить отовсюду, где могут находиться музыканты,

а технология позволяет нам делать это пространство частью своего собственного.

…Я хочу связать музыканта с пространством вокруг него таким образом, чтобы он

больше не мог играть традиционную роль «скрипача, сидящего на стуле перед пюпитром».

Карлхайнц Штокхаузен

Замысел «экспедиции»

Первопричины. - Главные цели. - Новые земли

Музыкальный потенциал виртуальных пространств всё ещё остаётся тем таинственным «Южным материком», отыскать который европейцы стремились веками, а до тех пор обозначали на картах как нечто огромное, но не имеющее ни точных размеров, ни определённой формы., Учитывая живейший интерес многих композиторов второй половины ХХ века, включая таких мастеров как К. Штокхаузен, Л. Берио, Я. Ксенакис и Дж. Кейдж, к охвату всего доступного реального пространства зала, созданию подобия 3D-звука, это более чем странно1 Конечно, возможности эры зарождения компьютерных технологий, времени экспериментов 50-70-х годов, не позволяли ещё перенести возникающий новый опыт в виртуальную среду. Бурное развитие цифровых средств вплоть до первого десятилетия XXI века дало в руки музыкантов мощный инструментарий. Однако и по сей день интерес к технологической стороне превалирует над собственно музыкальным творчеством, поэтому новые «пространства» и сегодня – музыкальная terraincognita. Оставив в стороне причины такого несоответствия, отметим, что очертания «новых земель», наполняющих цифровой «океан», постепенно всё же становятся более определёнными благодаря усилиям музыкантов и исследователей разных стран, континентов и музыкальных «вероисповеданий».

Их, пока ещё достаточно робкие, «путешествия» в виртуальные пространства музыки, позволили наметить некоторые «маршруты», а творческие и научные методы – определить необходимые «снаряжение» и «оснастку» исследовательских «кораблей». Тем не менее, в силу незначительного количества «вылазок» и огромности цифрового «мира», пока ещё рано говорить о «заселении» открытых музыкальных «островов» и «архипелагов». Описываемая в статье, незавершённая пока ещё музыкальная «экспедиция» старается внести свою скромную лепту в открытие и изучение новых пространств и новых «земель» музыкального макрокосмоса.

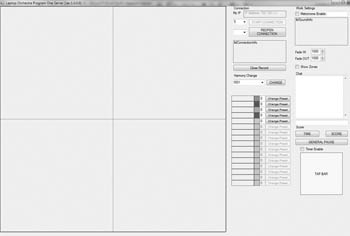

С недавних пор (точнее, с начала 2009 года) в Ростовской государственной консерватории им. С. В. Рахманинова идеи изучения областей интерактивной музыки и виртуального пространства материализовались в музыкально-исследовательский проект, который, по предложению автора данной статьи, назвали в духе экспериментальной эпохи: EXPLAIN. EXPLAIN (англ. объяснять; раскрывать) расшифровывается как EXPerimental LAptop INtercommunication, т. е. экспериментальное взаимодействие лэптопов (ноутбуков). По сути, это и несколько специально написанных компьютерных программ, и творческий эксперимент, и исследовательский проект: в настоящий момент, это процентов на 80 – исследование, на 20% – получение нового музыкального опыта (илл. 1).

Первотолчком было желание изучить творческий потенциал исполнителя и композитора в иной акустической и ансамблевой среде. Потом пришло понимание гораздо более широкой художественной и исследовательской перспективы – а также и технической проблематики, связанной с сетью как музыкальным инструментом, ансамблевым взаимодействием, исполнительскими взаимоотношениями, которые мы назвали координацией и кооперацией.

Изначально ядро концепции состояло в том, что каждый исполнитель, в равной степени с остальными, может заполнять всё окружающее звуковое пространство. Более того, размещение звуковых элементов ограничено лишь возможностями акустической системы, исполнительская же фантазия потенциально не сковывается ничем. В результате, рождается сложное взаимодействие различных взаимопроникающих звуковых пространств, ведь каждый исполнитель, участвуя в общей картине «миросоздания», творит и свой собственный звуковой мир.

Понимая, что нельзя «объять необъятное», в рамках проекта мы проложили «маршрут экспедиции» к трём малоизученным «землям»: виртуальному музыкальному пространству, сетевому музыкальному исполнению и интерактивной музыке. Поскольку сегодня эти явления ещё не вошли в традиционный обиход российского музыкознания и, следовательно, нуждаются в некотором предварительном комментарии, будет правильным несколько подробнее остановиться на специфике всех исследовательских позиций.

«Новые земли»

Виртуальное музыкальное пространство

Исполнительский процесс в explain’овской реализации происходит одновременно в двух акустических пространствах: реальном и виртуальном. Пространство аудитории или зала, в котором размещаются исполнители и воспроизводящая аудиосистема, формирует трёхмерное реальное акустическое пространство. Создаваемая цифровым способом компьютерная модель открытого (незамкнутого) 3D-пространства образует виртуальное пространство звука. В то время как реальное пространство функционирует согласно физическим законам константной реальности, создаваемый компьютером тип звукового пространства обладает всеми характеристиками виртуальной реальности. Создаваемый активностью константной реальности в текущий момент времени, возникающий виртуальный звуковой «океан» характеризуется автономностью и интерактивностью [2].

В создаваемой программой EXPLAIN звуковой среде, как и любой другой виртуальной реальности, своё, отличное от константной реальности, пространство и законы существования виртуальных объектов и звуковой энергии. Прежде всего, размеры виртуального пространства могут принципиально отличаться от величины аудитории или зала, образующих акустическую область константной реальности. Так, виртуальная площадь в программе составляет примерно 3500 м2, в то время как размер реального помещения – от 25 м2 (аудитория) до 500 м2 (камерный зал). Отличаться могут и формы двух пространств: в нашем случае, виртуальное пространство представляет собой куб, концертный зал такой формы на практике встречается крайне редко.

Поскольку пространство виртуальной реальности независимо по отношению к константной реальности, оно может менять свои характеристики, в том числе размеры и форму, находясь в одной и той же константной реальности. Постоянство же геометрических параметров виртуальной реальности, при существовании её в неодинаковых областях константной реальности (например, при воспроизведении в различных помещениях, с применением различных акустических систем), создаёт обратный эффект переменности.

Акустические законы также иначе ведут себя в виртуальной реальности, вплоть до фундаментальных физических констант (например, скорости распространения звука в воздушной среде). Так, звук от источника сигнала может распространяться во все стороны равномерно, при этом затухание колебаний может происходить и согласно законам константной реальности, однако одновременно могут отсутствовать любые отражения, что формирует совершенно отличное от физического мира диффузное звуковое поле. Более того, виртуальное пространство может вообще не иметь свойств поглощения, преломления или отражения звуковых волн.

В цифровом мире (если позволяют законы «актуальной» на данный момент виртуальной реальности) любые объекты могут мгновенно перемещаться в любом направлении и любую точку доступного пространства без каких-либо изменений своего состояния. Источник звукового сигнала является таким же объектом, поэтому легко заставить звук «прыгать», а при быстром его перемещении – «игнорировать» эффект Доплера. Поскольку звуковой объект может, в итоге, размещаться практически в любом месте виртуального пространства, во многих случаях он может оказаться и в «недоступных» для константной реальности точках координат (к примеру, на десятки «виртуальных» метров «ниже» уровня слушателя)

В нашем проекте у каждого исполнителя, по сути, своё виртуальное пространство, к звучанию и свойствам которого он может обращаться в любой момент времени (через интерфейс программы и подключённые к лэптопу наушники) – и общее, где соединяются вместе все отдельные пространства, которое затем преобразуется в акустическое поле константной реальности. Как следствие, в звуковой модели EXPLAIN’а возникает сложное взаимодействие константной и виртуальных реальностей, что требуется учитывать не только в технологическом ключе, но, прежде всего, во всех аспектах музыкального процесса. Собственно, именно от сложного взаимодействия двух реальностей и берут начало «земли» интерактивного взаимодействия.

Интерактивное взаимодействие

Интерактивная музыка в целом, находясь на стыке алгоритмической и электронной музыки, в то же время привносит в новое сочетание и ряд характерных, только ей присущих качеств. Два ключевых аспекта выделяют интерактивную музыку в самостоятельную область музыкального творчества: исполнение в реальном времени и наличие возможности у исполнителя влиять, в тех или иных пределах, на развитие композиции в процессе исполнения. Поскольку при этом вариативность как принцип распространяется как на музыкальный материал, так и на временные и пространственные структуры, исполнение приближается к импровизации и, соответственно, отсутствию, с точки зрения компьютера, заранее определённой, устойчивой композиции.

Интерактивную музыку можно определить как систему специфического взаимодействия между исполнителем (или группой исполнителей) и компьютером, с обязательным наличием «обратной связи» в процессе исполнения в реальном времени. Другими словами, компьютер выступает на правах «виртуального» исполнителя, своими действиями побуждая «реального» исполнителя к реакции на воздействие. Специфика же «обратной связи» (определяющей то, как компьютер отвечает на «воздействие»), в совокупности с техническими, акустическими и пространственными свойствами образует музыкальное качество, позволяющее охарактеризовать компьютерную систему как специфический музыкальный инструмент, а исполнение – как взаимодействие музыканта с этим инструментом. При этом, что характерно, свойства компьютерного «инструмента» ничем не отличаются от «исторического» акустического музыкального инструмента – со всеми вытекающими из этого последствиями.

Каждый музыкальный инструмент обладает собственным набором свойств, характеристик, которые отличают его от других инструментов. Различия касаются не только тембра, звукового и динамического диапазонов, но также и особенностей звукоизвлечения, набора технических приёмов, потенциально доступных исполнителю и пр. Это позволяет во всех случаях, говорить как об уникальности акустических инструментов разных групп (например, скрипки и трубы), так и о своеобразии их внутри одного вида (например, тромбона и тубы). Исходя из этого постулата, некоторые исследователи предлагают для описания уникального набора характеристик музыкального инструмента использовать термин «идиоматичный» [27, р. 274].

В пространстве интерактивной музыки компьютер предстает обладающим той же идиоматичностью, что и акустические инструменты. Подобно своим историческим предшественникам, она складывается из набора технических и программных решений, особенностей системы взаимодействия с исполнителем (в т. ч. через так называемый «интерфейс»), тембровых, пространственных возможностей и т. п. Таким образом, практически в каждом частном случае применения компьютера как инструмента мы чаще всего получаем новый (или, как минимум, дополненный) набор качеств, т. е. новую идиоматичность, новый музыкальный инструмент.

Что это значит для исполнителя? То же, что и в случае с историческими «родственниками»: для того, чтобы выявить потенциальные возможности нового инструмента, исполнитель должен научиться играть на нём. Иначе говоря, пройти весь путь овладения им: от формирования навыков моторной координации до выявления его акустических ресурсов.

Когда музыканты объединяются в коллективы – а музыкальный процесс нуждается в нескольких исполнителях, – компьютер, оставаясь «индивидуальным» инструментом, вместе с тем становится и некоторым объединяющим началом. В совместном же исполнении возникает ряд новых композиторских и исполнительских проблем, проистекающих от специфики коллективной игры в интерактивной музыке в целом и сетевом музыкальном исполнении в частности.

Сетевое музыкальное взаимодействие

Музыкальные коллективы как специфические социальные группы можно проследить вплоть до времен культуры палеолита. Музицирование – фундаментальная групповая деятельность, которая всё чаще совершается с использованием электронных сетевых средств. Сохранение и в этом случае возможности исполнения не хуже времен «человека умелого» требует лучшего понимания их функционирования. Независимо от задач, которые ставит процесс совместного музыкального творчества (будь то композиция, исполнение или импровизация), каждый музыкант неизбежно сталкивается с различными «сценариями» коллективного исполнительства. Подобным же образом компьютерная сеть базируется на координации и кооперации. С 70-х годов ХХ века это легло в основу понимания новых возможностей, которые привносят компьютерные науки и цифровая инфраструктура в процесс музыкальной коммуникации [5].

Вплоть до начала 1990-х годов музыкальные системы, в которых интерактивность обеспечивалась цифровыми технологиями, большей частью основывались на локальных сетях – из-за ограничений электронных и телекоммуникационных возможностей того времени. Однако недавний технологический взлёт, в том числе в глобальной среде, сделал возможным применение обычными компьютерными пользователями (к каковым, справедливости ради, относится и большинство музыкантов) ранее недоступных средств.

По сути, компьютерная коммуникация и повсеместный характер распространения сетей различных масштабов открыли новую грань, которая также охватывает контекст звукового и музыкального искусств. Она включает в себя не только появление новых типов музыкальных инструментов, но и переопределение функциональных ролей композитора, исполнителя и слушателя в музыкальном процессе. Более того, она предоставляет – и для «индивидуальных» творцов, и для творческих групп – возможности экспериментирования и интерактивного взаимодействия в области музыки.

Термин network musical performance, предложенный Дж. Лаззаро в 2001 году [15], используется в зарубежном музыкознании преимущественно для обозначения музыкальной интерактивности в Интернете Применяемый нами термин сетевое музыкальное исполнение, предложенный позднее автором данной статьи [1], предполагает более общее определение сети и, соответственно, включает как глобальные, так и локальные сети.

Сетевое музыкальное исполнение можно определить как форму коллективного искусства, которая осуществляется одновременно и интерактивно между реально или виртуально разделёнными участниками. Исполнители, компьютерное оборудование и программное обеспечение образуют виртуальное исполнительское пространство, которое становится сценической площадкой для «локального» или «глобального» сетевого коллектива.

Как показывают существующие проекты, даже привычные музыкальные действия в традиционном репертуаре, в сочетании с дистанцированностью любого типа, характеризуются как интерактивные, а использование сети в творческой практике говорит об интерактивном характере практически любого творческого акта. В таком контексте сеть уже не просто медиум, а цифровой музыкальный инструмент, отдельные качества которого – ресурсы и средства выразительности, составляющие его идиоматичность в сетевом музыкальном исполнении.

Совершенно очевидно, сетевому исполнителю предстоит так или иначе преодолевать по сути те же акустические и инструментальные проблемы, что и традиционному музыканту. Поскольку освоение новых исполнительских техник, равно как и новых типов координации и кооперации – дело весьма ресурсоёмкое, требующее немалого времени и таланта от всех участников, больших финансовых вложений в технологии и исследования, – в сетевом музыкальном исполнении приходится выбирать между двумя путями. С одной стороны, заманчиво и, как было отмечено выше, творчески перспективно выглядит возможность использования музыкально-выразительных средств сети. С другой – максимально возможное приближение сетевого исполнения к традиционному выглядит оправданно, особенно учитывая определённый (и зачастую весьма сильный) консерватизм слушательской аудитории. Разумеется, возможен и третий путь – компромиссный по отношению к первым двум, пытающийся согласовать творческую потенцию и техническую затратность.

Подготовка «экспедиции»

Снаряжение. – Провиант. – Оснастка. – Команда.

«Снаряжение»

Хотя, вероятно, каждый компонент экспериментальной системы по-своему важен, именно программное оснащение, «движок» системы чаще других становится камнем преткновения на этапе разработки проекта и последующей головной болью исследователей в процессе дальнейших опытов. Это и понятно – без хорошо продуманного и, в случае сценической демонстрации, отлаженного программного ядра все последующие опыты становятся мало или вообще неосуществимыми. По сути, это – «корабль» для плавания, оттого изначально правильный выбор подходящей «посудины» может в итоге определить успешность всей «экспедиции» (кампании).

В зависимости от опыта исследователей в области программирования им приходится идти тремя путями. Первый путь – написание собственного программного кода на одном из языков программирования (в принципе, неважно каком) с эпизодическим использованием различных сторонних библиотек. По мере развития, из недр таких проектов выходят, в ряде случаев, собственные библиотеки для работы со звуком и даже небольшие языки программирования [7]. Путь этот, пожалуй, наиболее труден в техническом плане (одни только усилия, затрачиваемые на отладку, занимают до половины всего времени работы), что с лихвой окупается гибкостью и простотой использования, лёгкостью и скоростью добавления и корректировки новых элементов и функций.

Эти же (или какие-то другие) программные среды, пополнившись новыми функциями и некими началами интерфейса, переводят работу на другой уровень, становясь основанием для движения по второму пути: использовать специализированную программную среду, сфокусированную на работе со звуковым материалом и акустическим пространством [8], [26]). Для исследователя, имеющего неплохие представления о программировании в целом и звука в частности, но не владеющего серьёзно никаким распространённым языком программирования (или не рискующим погрузиться в эти дебри), этот путь, наверное, оптимальный.

Последний, третий путь, состоит в использовании в качестве «движка» приложение визуального «программирования» вроде Max/MSP[16] или Quartz Composer [22]. Достоинства большинства таких систем: проработанный интерфейс, стабильность, отсутствие необходимости глубоко разбираться в программировании (что весьма актуально для многих музыкантов) и тратить время на отладку. За это удобство, конечно, приходится платить – в прямом и переносном смысле. Помимо относительно высокой стоимости некоторых «готовых» программных решений, основной недостаток всех «визуальных» или «модульных» сред – невысокая скорость работы в процессе создания алгоритмической схемы и сравнительно малые гибкость и масштабируемость на последующих этапах «улучшения», отягощённые, к тому же, неизбежной «визуальной» перегруженностью. Кроме того, на изучение наиболее «продвинутых» комплексов (вроде упомянутого Max/MSP) приходится, по скромному мнению автора, затрачивать времени не меньше, чем на освоение среднестатистического языка программирования.

В качестве ремарки отметим, что исторически все коммерческие продукты в области работы со звуком (и, насколько можем судить, также и в остальных областях) явились результатом «доведения до ума» (то есть «дружелюбного пользовательского интерфейса») систем программирования звука, которые, в свою очередь, начинались практически «с чистого листа». Другими словами, «сердцевина» у программ разных визуальных и языковых структур может быть одна и та же (MUSIC – PureData[21] – Max/MSP).

Нужно заметить, что немалое число различных программ, языков и систем программирования в области экспериментальной работы со звуком создано в процессе опытов конкретного коллектива и, соответственно, под него и «затачивались». Конечно, существует возможность адаптировать существующий программный код или готовые модули под свои нужды, но чаще всего это процесс столь нетривиальный (и, к тому же, крайне скверно документированный), что любой собственный эксперимент «с нуля» выглядит куда более многообещающим. Более перспективным кажется использование коммерческих продуктов широкого спектра действия: в них и документация, как правило, содержится в большем порядке, и гарантирована (хотя бы на словах) меньшая «глючность».

В случае проекта EXPLAIN выбор практически сразу пал на предпочтительность следования по первому пути. Три основных момента послужили основанием для такого выбора. Во-первых, на тот момент имелся опыт разработки приложений (в том числе для работы со звуком) в среде Microsoft VisualStudio[17] – больший, чем в других системах, – поэтому использование CSound, ChucK и им подобных оказалось бы нерациональным.

Во-вторых, сказалась некоторая идиосинкразия автора к «спагетти» из коннекторов и модулей, которыми неизбежно отличаются системы «визуального» программирования. В-третьих, когда EXPLAIN только значился в проекте, такие разработки, как языковая среда ChucK, в качестве «флагманского корабля», в силу своей неразвитости на том этапе (речь, напомню, идёт о 2009 годе), никак не подходили. При том, что упомянутый язык несколько улучшился в последних версиях, он и сегодня всё так же недостаточно оптимизирован и способен «выпить всю кровь и жизнь из компьютера».[6]

В результате, кодовая часть программы написана «с чистого листа» на VB.NET и C#, а трёхмерное звуковое пространство моделируется с применением звуковой библиотеки fmod [12] (первоначально в проекте использовалась звуковая подсистема DirectX, однако отсутствие желания вручную контролировать распределение и освобождение ресурсов памяти вызвала потребность в готовом решении). Выбор fmodAPI2 определился также предоставляемой возможностью переключать «на лету» основные режимы воспроизведения звука – от моно до surround.

«Оснастка»

Программы проекта построены на клиент-серверной архитектуре, что потенциально позволяет экспериментировать в области сетевого музыкального исполнения «на расстоянии». Однако сейчас, когда проблемы виртуального пространства остаются важнейшими, все исполнители располагаются в одной аудитории. Всего в «команде» может быть до 20 человек, хотя в теории допускается более чем 200 музыкантов (впрочем, стоит опасаться, что при превышении какого-то разумного предела наш «корабль», поглотив и без того небезграничные ресурсы сервера, просто «пойдёт ко дну»). Музыканты – каждый со своим лэптопом, – подключаются по беспроводной сети к серверу, который выполняет задачи соединения всех клиентских процессов в одно целое с последующим воспроизведением через «реальную» акустическую систему, а также осуществляет синхронизирующие и «дирижёрские» функции. В продолжение нашей «экспедиционной» метафоры его можно было бы назвать «капитаном» или, скорее, «помощником капитана» (поскольку, как правило, за его работу отвечает, помимо компьютерного алгоритма, ещё и автор этих строк). Такое решение нельзя назвать традиционным – гораздо чаще сервер выполняет лишь синхронизирующие функции ([23], [14] и др.), – но именно оно в наибольшей степени отвечает поставленным нами исследовательским задачам.

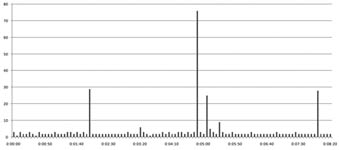

Как упоминалось выше, звуковая библиотека fmod предоставила в наше распоряжение много вариантов акустических схем. Поэкспериментировав в этом направлении, мы пришли к наиболее устраивающей нас реальной акустической системе – квадрофонической. Прочие системы объёмного звучания (DolbySurround, Dolby Pro Logic [10] и др.) были отбракованы в силу их ярко выраженной кинотеатральности, что выражалось в смещении акустического центра в сторону фронтальных колонок. Нам же нужно было «равновесие» - и квадрофоническая система с её равноправием всех источников оказалась, в нашем случае, самой подходящей (илл. 2).

В поисках пространственных решений в ансамблевой музыке возможны три основных подхода. Первый используется наиболее часто, поскольку предъявляет минимальные требования к акустической части и встречается практически во всех концертных залах. Речь идёт об акустических системах, расположенных фронтально к слушателю вдоль сцены. Получая на выходе достаточно банальное для экспериментальной музыки стерео, мы, с одной стороны, сохраняем для слушателя привычную акустическую среду, с другой – весьма ограничиваем себя в важнейшем выразительном средстве.

При втором подходе, наиболее характерном для коллективных исполнений (в рамках группы или даже электронного оркестра), каждый из исполнителей оснащается своей индивидуальной акустической системой. При всей простоте такого подхода, сама задача отнюдь не легка, ведь технически нужно добиться того, чтобы исполнители слышали друг друга и при этом слушатель воспринимал множественность акустических источников естественно. Оригинальная конструкция индивидуальных акустических систем спроектирована и реализована в нескольких американских университетах, в том числе Стэндфордском и Принстонском [4]. Как видно, в данном случае мы практически получаем ясно пространственно локализованного «классического» исполнителя.

Однако в интерактивной музыке стремление отойти от привычной схемы расположения исполнителей приводит также к идее поместить исполнителя и слушателя внутрь единого акустического пространства – виртуального и реального. Соответственно, изменяется сама система взаимоотношений исполнителя со звуковым окружением, поскольку в данном случае оно само выступает в роли музыкального инструмента. Изменяются и взаимоотношения исполнителя со слушателем – и слушателя с сочинением. В такой множественной корректировке восприятия и взаимодействия таится характерная для всей компьютерной музыки опасность окончательной потери и так зачастую слабых традиционных исполнительских и слушательских «привычек», что приводит к «дезориентации» слушателя, невозможности воспринять и принять новый художественный опыт.

«Провиант»

Поскольку одной из движущих идей проекта остаётся исследование музыкально-выразительных возможностей виртуального 3D-пространства, установление принципов размещения в нём звука с применением различных проекций и систем координат изначально было приоритетной задачей. Однако невозможно отображать в пространстве «традиционные» аудиотреки или звуковые потоки как некие визуально привычные фигуры (как делает большинство аудиоредакторов для графического представления звуковой волны), поскольку в данном случае мы взаимодействуем не с временными, а с пространственными характеристиками звука.

Поэтому мы определяем любой звуковой фрагмент произвольной длины, позволяющий позиционировать себя в пространстве, как звуковой элемент. Последний размещается в определённой исполнителем точке трёхмерного пространства; при этом само звучание, содержащееся в элементе, может быть по своим акустическим характеристикам «шире» этой точки. Важно, что звуковой элемент определяется как цельный объект и допускает все манипуляции – перемещение, копирование, удаление и т. п. – которые могут относиться к любому виртуальному объекту. При этом содержание («тип») конкретного звукового элемента может быть каким угодно – от предварительно записанных звуковых фрагментов и «лупов» до алгоритмически рассчитываемых последовательностей звуков и синтезируемых в режиме онлайн звуковых и шумовых комплексов.

Однако широта выбора звуковой палитры в случае потребностей конкретной композиции, требует предварительного отбора и «типов» элементов, и их содержания. Поскольку структура программы и методы исполнения у нас интерактивны, предварительный набор звуковых элементов (музыкальный «провиант» нашей «экспедиции») должен учитывать эту специфику. Собственно, именно поэтому soundscape3 как стилистика создаваемых звуковых пространств не просто подходит в наибольшей степени, но естественным образов вытекает из всех вышеперечисленных обстоятельств. К счастью, для небольших вылазок к близлежащим островам скромного набора из пары десятков элементов бывает вполне достаточно, в целом же серьёзные «броски» требуют столь же серьёзной экспериментальной композиторской работы – а это тема, безусловно достойная отдельного научного труда.

«Команда»

Большую часть времени в проекте на постоянной основе одновременно задействовано 3-4 человека. С большим числом членов «экипажа» возникают сложности аудиторного порядка, к тому же сейчас и нет стремления «взять» количеством. Более того, введение каждого нового участника требует определённого репетиционного времени, поскольку освоение виртуального звукового пространства – задача не одного дня. Если на освоение интерфейса и принципов работы у новичка уходит пара минут, на знакомство со звуковыми элементами – пара часов, то на начальное «привыкание» к новым звучаниям, возникновение «чувства» пространства – несколько полуторачасовых репетиций. Стоит упомянуть также, что на данном «отладочном» этапе большинство участников проекта – музыканты с хорошей компьютерной и звукорежиссёрской подготовкой.

Предварительная профессиональная подготовка, тем не менее, оказалась «палкой о двух концах». С одной стороны, процесс вхождения в совместное музицирование в относительно новой для всех участников стилистике «звуковых ландшафтов» был весьма скорым и с хорошим музыкальным откликом. В тоже время, довлеющий опыт академического музицирования и традиционного звуковосприятия до известной степени мешал быстрому включению слухового контроля и внимания в новом виртуальном контексте. Поэтому всем участникам «экспедиции» предоставлялась неоднократная возможность самостоятельного изучения «навигационных систем» «судна», ведь каждому необходимо было «пощупать» виртуальное пространство, скоординировать экранную двухмерную информацию о позиции звукового элемента с его реальным акустическим воплощением, соотнести масштабы виртуального и реального акустических пространств.

«Экспедиция»

Маршрут. – Течения. – Опасности пути.

«Маршрут»

Маршрут нашей «экспедиции» до момента «отплытия» был проложен, что называется, «по прямой»: от начальной первоидеи – до исполнения, тогда еще гипотетического, в виртуальном пространстве. Поскольку многие «мели» и «рифы» нам были поначалу неведомы, всё большая извилистость предстоящего пути стала очевидной лишь по мере продвижения «вглубь». С первых шагов сам проект и сопутствующее «снаряжение» стали видоизменяться – как соответственно новым задумкам, так и в процессе корректировки прежних идей. Однако, дабы не утомлять читателя ненужными подробностями, опишем лишь ключевые особенности функционирования программы в том виде, в каком она существует на момент написания этих строк.

«Исполнительская» часть (клиентское приложение) позволяет формировать наборы звуковых элементов, также возможно сохранять и загружать по необходимости эти наборы как «пресеты» (илл. 3). Как было отмечено выше, звуковые элементы в любом количестве переносятся исполнителем на двухмерную проекцию трёхмерного виртуального пространства: от идеи размещения изначально в 3D пространстве пришлось отказаться в целях большей наглядности. Таким образом, для исполнителя элементы визуализируются в горизонтальной плоскости (координаты X и Z), вертикальное позиционирование звука (координата Y) осуществляется через изменение цифровых значений соответствующего поля ввода. Способ ввода, в действительности, никак не ухудшает пространственных характеристик звука (включая реверберацию, тембр и пр.), однако в пределах компьютерного графического представления позволяет добиться определенной наглядности и естественности манипулирования элементами. Наиболее удачные (или экспериментально подобранные) схемы расположения звуковых элементов в пространстве можно также сохранить в виде «пресетов».

Как показала практика, исполнителям, сидящим за ноутбуками, сложно (собственно, почти невозможно) общаться вербально или с помощью каких-то визуальных сигналов; к тому же, часто возникает необходимость передачи некоторой технической информации. Для целей улучшения ансамблевой координации, в программе предусмотрен «чат» между исполнителями, а также между «командой» и «капитаном» (т. е. между клиентами и сервером). Кроме того, «капитан» может рассылать сообщения, и даже «приказы» (например, используются «команды» смены наборов звуковых элементов, «дирижёрские» указания согласно «партитуре» и т. п.) всем членам «команды» одновременно. Насколько можно судить по ряду признаков (например, использованию Open Sound Control [19] в качестве протокола передачи данных), подобные же «чаты» организованы в большинстве цифровых коллективов.

«Управляющая» часть (серверное приложение) выполняет различные организующие и звуковоспроизводящие функции, важнейшие из них, с точки зрения музыкального процесса, – ритмическая синхронизация и управление композиционными аспектами (илл. 4). Для этого используются различные методы: для организации ритма применяются всевозможные таймеры и синхроимпульсы, для управления формой и музыкальной динамикой – некое подобие «партитуры». Кроме того, изучаются также способы координации и кооперации в различных ладовых системах, поэтому на сервере лежит и задача управления логикой гармонического развития соответственно заранее заложенным схемам.

Взаимодействие «клиентов» и «сервера» возможно в трёх режимах: «без синхронизации», «автоматическая синхронизация», «ручная синхронизация». В первом режиме данные поступают «как есть», поэтому, с учётом возникающих сетевых задержек и времени обработки информации, между звуковыми элементами возможна рассинхронизация. Поэтому данный режим применяется преимущественно в музыкальной стилистике, сочетающей soundscape и darkambient. В этом режиме, кроме того, члены «команды» имеют возможность учесть и компенсировать – довольно приблизительно – возникающие задержки. В «автоматическом» режиме задействуются таймеры, «пульсирующие» соответственно темпу композиции. Здесь момент возникновения звука полностью предсказуем и синхронизирован с общей метрической пульсацией. Любопытно, что исполнителю, после некоторой практики, весьма удобно «играть» в такой манере: ощущения «предчувствия» момента синхронизации близки тем, что исполнитель на духовых инструментах чувствует в момент начала игры. Наконец, в третьем, «ручном» режиме синхронизации, все уже размещённые в пространстве, но не начавшие звучать элементы «ждут» дирижёрского «ауфтакта»: их воспроизведение начинается по «команде» сервера.

Разумеется, в исследовательском проекте все действия исполнителей не могут подробным образом не фиксироваться. Запись ведётся непрерывно в отдельный файл (как сказали бы программисты, «ведётся лог»), данные которого затем служат источником информации для «аналитического» модуля. Анализ explain’овских сессий осуществляется с помощью специальной – третьей по счёту в проекте – компьютерной программы. В ней всю сессию можно изучать «вдоль и поперёк»: пошагово и в режиме «реального времени», выделяя и прослушивая исполнение отдельных членов «команды», строя различные графики и т. п. Есть также специальный «графический» режим для просмотра взаиморасположения звуковых элементов у каждого исполнителя в общем пространстве (об особенностях позиционирования элементов – см. ниже)

«Течения»

К настоящему моменту в мировой ансамблевой практике состоялось несколько достаточно успешных «вылазок» в те области цифрового «океана», где лежат «архипелаги» и «континенты» неизведанных «земель». Во всяком случае, технологические «находки», открытие новой «флоры и фауны» сетевого и ансамблевого музицирования позволяют говорить о зарождении иных видов и модификации существующих типов музыкальной практики. Вот лишь некоторые группы исследователей и музыкантов, пробовавшие или продолжающие «плыть» в сторону «Южного материка» (в скобках – год основания коллектива): Quintet.net (1999), Laptop Orchestra (2002), Princeton Laptop Orchestra (PLOrk) (2005) [20] (и его «клоны» – Stanford Laptop Orchestra (SLOrk) (2008) [25]; Dublin Laptop Orchestra (2011) [11]), Moscow Laptop Cyber Orchestra (2006) [18].

Хотя, в сравнении с вышеназванными коллективами, проект EХPLAIN плывёт своим «курсом», и часто маршрут его «экспедиции» пролегает в малоизученных «широтах» – а быть может, именно поэтому, – точные сведения о путях, которыми двигались «предшественники», были бы весьма ценны. В любом случае, это помогло бы избежать буквального следования уже пройденными «трассами», получить представление о «ветрах» и «рифах», ожидающих в предстоящем «путешествии».

К сожалению, сознательно или инстинктивно, многие исследователи в буквальном смысле уподобились мореплавателям прошлого. Как и первооткрыватели новых земель в течении многих веков, исследователи виртуальных звуковых просторов настойчиво скрывают и свои программные решения, и зафиксированные в «партитуре» музыкальные находки4. Конечно, никто и не ожидает, что передовые исследователи будут раздавать «направо и налево» свои творческие разработки, однако сегодня приходится констатировать большую «закрытость» всего экспериментального процесса, как в техническом, так и, особенно, музыкально-практическом аспектах.

В итоге значительная часть экспериментальных наработок представляет собой своего рода «устное» творчество, передающиеся «по наследству» знания (это хорошо заметно, например, при сравнении историй создания оркестров лэптопов [20; 25; 11]), многие сведения об «оснастке» не разглашаются, «координаты» «новых земель» даются неточные. Практически, лишь исследователи группы Quintet.net не только в общих чертах описали свой новый опыт, но и предоставили всему музыкальному сообществу инструментарий (ту самую «оснастку») для «экспедиций» к новым «материкам». К сожалению, даже специально создающиеся языки музыкального программирования (CSound, ChucK, и прочие) вопреки декларациям их создателей, чаще всего не предоставление «оснастки», а лишь скорректированный для работы с музыкальным материалом набор базовых «кирпичиков» (т. е. «доски», «гвозди» и «смола», из которых можно построить «корабль», но не уже снаряжённое «судно»). Как результат, почти всем исследователям волей-неволей приходится «изобретать велосипед»; это, несомненно, замедляет работу даже опытных «мореплавателей», новичкам же (особенно, не владеющим навыками программирования) зачастую путь в эти «воды» вообще закрыт.

«Опасности пути»

«Интерактивные опасности»

В интерактивной музыке, где доля компьютерного «участия» весьма высока, непросто добиться баланса между алгоритмической предопределённостью и творчеством. «Жёсткая» заданность последовательности действий лишает композицию исполнительской воли, неограниченная свобода делает музыку структурно аморфной.

Исполнитель не должен чувствовать себя как в детской компьютерной игре, где для выполнения каких-то действий нужно просто многократно кликать мышкой (желательно, в быстром темпе) или совершать движения курсором вверх-вниз «до умопомрачения». Не должен он и чувствовать себя «дрессированным медведем», выполняющим из раза в раз однотипные, часто не слишком осмысленные действия. Подобный подход, тем не менее, достаточно часто практикуется не только в репетиционном процессе [20; 25], но даже в концертной практике [20]. Конечно, полностью освободить исполнителя от некоторых «рутинных» действий почти невозможно, как в принципе неосуществима полная свобода даже в интерактивной и импровизационной моделях.

В структуре любой композиции есть различные функциональные уровни (в простейшем случае, мелодия – бас – аккомпанемент), каждый из которых находится в балансе, в том числе громкостной динамики, с остальными уровнями. Соответственно, в ряд композиций закладывается разделение функций между исполнителями и вводится понятие пространственных зон. Сами зоны представляют собой произвольные, но предварительно определённые «композитором», участки на виртуальной «сцене», каждому же исполнителю предписывается размещение звуковых элементов на предназначенной ему «территории». Стоит ли говорить, что зоны, являясь виртуальными объектами, могут быть не только статическими областями, но и динамическими «подпространствами» общего виртуального «мира».

Деление пространства на «зоны» неожиданно положительно сказалось на решении другой проблемы, с которой пришлось столкнуться в работе. Как известно, один из заметных психологических аспектов работы с графическим компьютерным интерфейсом состоит в том, что пользователь начинает явным образом демонстрировать свою «любовь» к симметрии (либо асимметрии) всегда, когда в программе есть возможности «рисования» или произвольного расположения графических элементов (меню, диаграммы, «автофигуры» и т. п.). Такая «любовь» проявилась и у наших исполнителей, поскольку программа допускает возможность свободного размещения звуковых элементов в «мониторном» 2D-пространстве. Как показал анализ проводимых explain’овских сессий, даже при отсутствии всех «соблазнов» компьютерной «игры» (так, по крайней мере, казалось автору), практически все участники на ранних этапах размещали звуковые элементы с явно выраженной симметричностью (часто), или намеренной не-симметричностью (реже). Разумеется, во многих случаях с этой «вредной» привычкой приходилось усиленно бороться самим исполнителям, так как динамика развития многих композиционных опытов настоятельно требовала комплексного подхода, различных ситуативных решений в расположении звуковых элементов.

«Сетевые опасности»

Для последовательной реализации сетевого исполнения, информация, независимо от типа содержимого, должна быть передана от «источника» к «приёмнику» аналогично принципам радиовещания или телефонии. Инфраструктура сегодняшних сетей характеризуется достаточно высоким качеством передачи аудио и визуальной информации, однако также отмечена значительными задержками в передаче данных – в зависимости от физической дистанцированности, качества связи и особенностей использования сети на аппаратном и программном уровнях. Поскольку музыка – очень чувствительная к фактору времени форма коммуникации, такие задержки, очевидно, должны быть настолько малы, насколько это возможно. Если же они превышают определённый предел, реалистичное музыкальное взаимодействие становится если не невозможным, то весьма проблематичным.

К сожалению, только в идеальном мире латентность в акустическом «путешествии» была бы вызвана только временем прохождения сигнала, то есть зависела лишь от расстояния между «источником» и «приёмником». В реальности действуют другие технологии: операционные системы как таковые, драйверы и кодеки, программные решения, естественный и неизбежный «человеческий фактор» – все это вносит свою лепту в этот процесс.

Запаздывание звука в сетевом музыкальном исполнении состоит из суммы «локальных» и «глобальных» задержек. «Локальные» инициируются музыкальными инструментами, временем прохождения аудиосигнала в воздухе до микрофона, от акустической системы обратно к исполнителю – плюс неизбежные затраты на компьютерную обработку. Как очевидно, любой алгоритм не выполняется мгновенно: даже при нынешнем колоссальном росте вычислительных мощностей, используемые кодеки, фильтры, преобразователи добавляют десятки миллисекунд к критической массе временных задержек. «Глобальные» можно определить как время, затраченное на то, чтобы информация, посланная из одной «точки» сети, была получена другой «точкой» [9].

В эталонных условиях, когда сигнал передаётся по сети со скоростью света и не существует никаких преград, его путешествие к конечной точке на другом конце земного шара займёт около 67 миллисекунд. За такой же период времени звук преодолеет в концертном зале (и любой воздушной среде) около 23 метров. В большом симфоническом оркестре расстояние между последним пультом первых скрипок и контрабасовой группой может достигать 30 метров и более. А задержка звука между первым рядом скрипок и медными духовыми достигает значения в 45 миллисекунд. Согласно же исследованиям в области психоакустики, порог, ниже которого запаздывания в звучании не заметны, составляет лишь 25-35 мс [13]. Поэтому, как хорошо известно из музыкантской практики, каждому исполнителю в большом коллективе приходится приспосабливаться не только к особенностям своего инструмента (например, валторнистам – к запаздывающей атаке), но и к разнообразным «опозданиям» звуковой информации, получаемой от других исполнителей в оркестре.

Поскольку сетевое музыкальное исполнение входит в исследовательскую «программу» проекта EXPLAIN, изначально решено было не затрачивать много сил на борьбу с латентностью, а сохранить их для более творческих дел. Полное устранение задержек тем более малодостижимо, учитывая, что каждый участник «команды» приходит со своим лэптопом.

В целом суммарная латентность в проекте складывается из задержек на четырёх «критических» участках системы: беспроводной сети, сетевом протоколе передачи данных (TCP/IP), серверных функциях обработки клиентских данных и звуковой библиотеке (fmod). Время серверного «отклика», измеренное с использованием функции ping(илл. 5),показывает как наличие минимальных задержек (1-3 мс) 98% времени, так и присутствие периодического кратковременного увеличения времени от 25 до 75 мс. Основная причина таких «всплесков» связана с особенностями функционирования Wi-Fi сетей и конкретного роутера, а также фоновыми процессами сервера. Протокол TCP/IP, используемый для передачи важной информации, в том числе о манипуляциях со звуковыми элементами, «по умолчанию» затратен по времени, поскольку всегда требует наличия обратной связи с клиентом: здесь временные «потери» могут достигать 30-40 мс. К сожалению, также используемый в программе протокол UDP для потребностей надёжной передачи данных, также «по умолчанию», не подходит. Собственные функции программы передачи и обработки информации довольно неплохо оптимизированы по скорости (и постепенно продолжают улучшаться). Однако даже использование многопоточности, при получении большого объёма данных от нескольких клиентов, не позволяет пока стабильно выйти на уровень «0 мс»: в среднем, здесь задержка составляет 10-15 мс. Наконец, четвёртый уязвимый компонент – звуковая библиотека fmod: здесь задержки могут быть очень заметными, поскольку итоговый звуковой «рендеринг» требует больших ресурсов (и, вероятно, лучшей оптимизации используемых алгоритмов). Как отмечают сами разработчики, время, необходимое для добавления звукового потока, может достигать 100 мс. В реальности, к счастью, все четыре участка редко бывают «на пике» латентности одновременно. Тем не менее, среднее значение задержки при добавлении звукового элемента – порядка 60 мс. Это несколько больше, чем в описанном выше случае симфонического оркестра, однако на практике исполнитель вполне в состоянии с этим справиться – и психологически, и музыкально.

Поэтому, вместо того, чтобы тратить львиную долю времени исследовательской работы на борьбу с задержками, участники проекта учатся «сотрудничать» с латентностью, приноравливаются к ней. А поскольку, в силу разброса значений задержек, композиции в большинстве случаев требуется ритмическая синхронизация, исполнители сражаются уже не с самими задержками, а приноравливаются к «пульсу» серверного метронома. С последним все участники проекта учатся взаимодействовать исполнительски, воспитывая в себе ощущение временного интервала между моментом помещения звукового элемента на «сцену» и моментом начала его реального звучания. Практика показывает, что удовлетворительный результат возникает тогда, когда исполнитель начинает ощущать это на психофизическом уровне – то есть, по сути, так же, как любой «традиционный» инструменталист в контексте своей специальности.

В любом случае, сам способ взаимодействия, сеть как связующее звено между музыкантами, начинает выступать в роли самостоятельного инструмента. Как справедливо отмечает ряд исследователей, «задержки» обязаны быть приняты составной частью этого своеобразного музыкального инструмента, поскольку являются слагаемым его идиоматичности. Композитор, сочиняющий для «сетевого» коллектива, должен, таким образом, не игнорировать латентность, а, напротив, трактовать её как музыкальное качество. Исполнителю же, аналогичным образом, придётся ориентироваться на это качество в исполнении.

«Опасности виртуального пространства»

Виртуальное звуковое пространство в текущей реализации проекта достаточно велико. «Заблудиться» в нём, конечно, не получится, тем более что и «карта» (интерфейс клиентской программы) всегда перед глазами. Однако если всё пространство доступно всем исполнителям, члены «команды» могут переставать слышать себя, свой виртуальный мир в общем массиве звучания. Применение «зон» для дифференциации исполнителей помогает тем, кто находится «ближе» к виртуальному слушателю (точке отсчёта системы координат), тем же, кто находится «дальше», это мало что даёт. По сути, это выглядит так, как если бы у «традиционного» музыканта симфонического оркестра собственный инструмент находился на другом конце сцены. Способ «приблизить» инструмент к его «хозяину» описан выше: каждый участник проекта может параллельно с общим звучанием слушать свое с использованием индивидуальных наушников.

Более сложная, пока ещё недостаточно нами изученная музыкально-психологическая проблема возникает в особых условиях сочетания музыкальной стилистики, «типов» звуковых элементов, интерактивных приёмов координации и кооперации. Речь идёт о «растворении» исполнителя в едином звуковом «ландшафте» – вплоть до потери собственной индивидуальности. Исполнитель как бы теряет «нити» музыкального «действа», заметным образом снижаются его творческие силы, начинается процесс механического «расставления» элементов на «сцене». Это происходит иногда и в случае использования наушников, и «включения» пространственных зон. Хотя точный «диагноз» нами ещё не поставлен, основная версия связывает происходящее с внутренним конфликтом исполнительского «Я» и новыми, менее «индивидуальными», функциями участника в рамках «стандартной» explain’овской сессии. Для решения этой проблемы – ознаменовавшейся появлением новых задач исследовательского плана, – в программу введён режим «солирования». Суть его состоит, как нетрудно догадаться, в предоставлении конкретному участнику возможности определённо проявиться в реальном акустическом пространстве: его, и только его исполнение воспроизводится через отдельную акустическую систему. Это позволяет музыканту «локализоваться» в пространстве – и с лёгкостью вернуть привычное «классическое» самовосприятие в общем контексте.

Вместо заключения

Ансамблевое музицирование, как и музыка в целом, всегда проявлялось как необходимая составляющая социальной активности и особой «кооперативной» коммуникации. Независимо от своей ритуальной составляющей, совместная творческая и исполнительская деятельности стала характерной чертой преобладающего большинства форм музыкальной практики.

Этот особый тип групповой художественной активности, по сути, является проявлением значимых социальных факторов. За свою многовековую историю он претерпел множественные трансформации и выкристаллизовался в определённые, устоявшиеся формы и типы сценического «поведения» и творческого «взаимодействия». Эти «сценарии» совместного музыкального творчества с конца XX века всё чаще видоизменяются соответственно возникающему новому опыту цифровой коммуникации. Этот «новый опыт» касается не только области электронных звучаний и поисков в сфере алгоритмических структур: всё музыкальное творчество оказывается в зоне влияния цифрового искусства – от инструментария до новых типов музыкальной «координации» и «кооперации».

Тем не менее, долгое время проблема взаимодействия исполнителей находилась на втором плане, значительно уступая технологическому аспекту. Даже такие коллективы, как «League of Automatic Music Composers» [29] и «The Hub» [28], заложившие фундамент сетевого музыкального исполнения, не внесли ничего принципиально нового в развитие принципов ансамблирования. Дело сдвинулось с мёртвой точки лишь в последние десятилетия, когда компьютер и исследователи «выросли» настолько, что первый стал претендовать на роль полноправного участника творческих актов, а вторые нащупали методы вовлечения «цифрового» исполнителя в «живой» музыкальный процесс. Пожалуй, именно с этого момента коллективное музицирование стало обретать новые формы.

Затевая проект EXPLAIN, автор вовсе не предполагал, как скоро проблемы совместного исполнения выйдут на один уровень с прочими исследовательскими и творческими задачами. Впрочем, это своеобразное «открытие Америки» стало, признаемся честно, «визитной карточкой» всего экспериментального направления в ансамблевом музицировании. Потому, дабы непростой путь в бурных «водах» виртуальных пространств и интерактивных экспериментов стал более «географически» ясным, а «снаряжение» будущих «экспедиций» – более надёжным и подходящим, – и написана эта статья. А поскольку и сам проект ещё продолжает своё «плавание», дальнейшие «отчёты» (т. е. материалы исследования и музыкальные «примеры») участники планируют размещать по адресу www.soundworlds.net/explain.

Примечания

- Справедливости ради, следует сказать, что отдельные опыты виртуальных звуковых пространств некоторые из вышеназванных композиторов всё же осуществляли (вспомним, для примера, CosmicPulses и Helikopter-Streichquartett К. Штокхаузена)

- API (англ. Application Programming Interface) – интерфейс программирования приложений; набор готовых классов, процедур, функций, структур и констант, предоставляемых приложением (библиотекой, сервисом) для использования во внешних программных продуктах.

- Soundscape (от англ. sound – звук, landscape – ландшафт; букв. «звуковой ландшафт») – звук или сочетание звуков, которые образуются или возникают путём погружения в звуковую среду окружающего мира. Термин "звуковой ландшафт" может также относиться к аудио записи или исполнению, которые создают ощущение особенной атмосферы, или к композиции, созданной как исключительно с помощью звуков акустической среды, так и в сочетании с другими компонентами музыкального «действа». [23]

- «… И он [Христофор Колумб – А. К.] говорит, что умышленно показывал более длинные дистанции пройденного пути, чтобы ввести в заблуждение пилотов и моряков, пролагающих курс на карте, и самому остаться господином дороги в Индии … И он желал, чтобы никто из них не знал верного пути, и чтобы никто не мог быть уверенным, что маршрут, которым он следует, приведёт его в Индии.» [3]

Список литературы

- Красноскулов А. В. Интернет как средство музыкальной выразительности // Проблемы музыкальной науки. Вып. №2(11). Уфа., 2012

- Носов Н. А. Манифест виртуалистики // Труды лаборатории виртуалистики. Вып. 15. М., 2001.

- Путешествия Христофора Колумба. Дневники, письма, документы. М., 2010.

- A History of Hemispherical Speakers at Princeton [Электронный ресурс]. URL: http://silvertone.princeton.edu/~skot/plork/delorean/history.html (дата обращения 01.12.2012)

- Bischoff J., Gold R. and Horton J., Music for an Interactive Network of Microcomputers // Computer Music Journal. 1978. №2.

- ChucK: Release [Электронный ресурс]. URL: http://chuck.cs.princeton.edu/release (дата обращения 01.12.2012)

- ChucK: Strongly-timed, Concurrent, and On-the-fly Audio Programming Language [Электронный ресурс]. URL: http://chuck.cs.princeton.edu (дата обращения 01.12.2012)

- CSound [Электронный ресурс]. URL: http://www.csounds.com (дата обращения 01.12.2012)

- Delane D., Ward T. and McLoon S. On Consistency and Network Latency in Distributed Interactive Applications: A Survey. Presence. Vol. 15. No. 2. 2006.

- Dolby Laboratories [Электронный ресурс]. URL: http://www.dolby.com (дата обращения 01.12.2012)

- Dublin Laptop Orchestra [Электронный ресурс]. URL: http://dublinlaptoporchestra.com (дата обращения 01.12.2012)

- fmod [Электронный ресурс]. URL: http://fmod.org (дата обращения 01.12.2012)

- Haas, H. The Influence of a Single Echo on the Audibility of Speech. Reproduced in J. Audio Eng. Soc.: Vol. 20, Mar. 1972: pp. 145-159.

- Laptop Orchestra [Электронный ресурс]. URL: http://laptoporchestra.net (дата обращения 01.12.2012)

- Lazzaro J., Wawrzynek J. A Case for Network Musical Performance // The 11th International Workshop on Network and Operating Systems Support for Digital Audio and Video (NOSSDAV 2001) June 25-26, New York, 2001.

- Max/MSP [Электронный ресурс]. URL: http://cycling74.com (дата обращения 01.12.2012)

- Microsoft Visual Studio [Электронный ресурс]. URL: http://www.microsoft.com/visualstudio (дата обращения 01.12.2012)

- Moscow Laptop Cyber Orchestra [Электронный ресурс]. URL: http://cyberorchestra.com (дата обращения 01.12.2012)

- Open Sound Control [Электронный ресурс]. URL: http://opensoundcontrol.org (дата обращения 01.12.2012)

- Princeton Laptop Orchestra (PLOrk) [Электронный ресурс]. URL: http://plork.cs.princeton.edu (дата обращения 01.12.2012)

- Pure Data (PD) [Электронный ресурс]. URL: http://puredata.info (дата обращения 01.12.2012)

- Quartz Composer [Электронный ресурс]. URL: https://developer.apple.com/technologies/mac/graphics-and-animation.html (дата обращения 01.12.2012)

- Quintet.net [Электронный ресурс]. URL: http://quintetnet.hfmt-hamburg.de/wiki/projects/quintetnet (дата обращения 01.12.2012)

- Soundscape [Электронный ресурс]. URL: http://en.wikipedia.org/wiki/Soundscape(дата обращения 01.12.2012)

- Stanford Laptop Orchestra (SLOrk) [Электронный ресурс]. URL: http://slork.stanford.edu (дата обращения 01.12.2012)

- SuperCollider [Электронный ресурс]. URL: http://supercollider.sourceforge.net (дата обращения 01.12.2012)

- Tanaka A. Interaction, Experience and the Future of Music // Consuming Music Together: Social and Collaborative Aspects of Music Consumption Technologies. 2006.

- The Hub [Электронный ресурс]. URL: http://www.o-art.org/history/Computer/Arifact/TheHubCd.html (дата обращения 01.12.2012)

- The League of Automatic Music Composers [Электронный ресурс]. URL: http://soundamerican.org/the-league-of-automatic-music-composers- (дата обращения 01.12.2012)